تحليل ومعالجة البيانات وادارة قواعد البيانات باستخدام بايثون ومكتباتها (حجم البيانات 20 عمود و2000 صف )

الوصف

تحليل ومعالجة البيانات الضخمة هو مجال أساسي في علوم البيانات والهندسة الحديثة، ويهدف إلى استخراج المعرفة والقيمة من كميات هائلة ومتنوعة من البيانات بسرعة وكفاءة. دعنا نفصلها بشكل منظم:

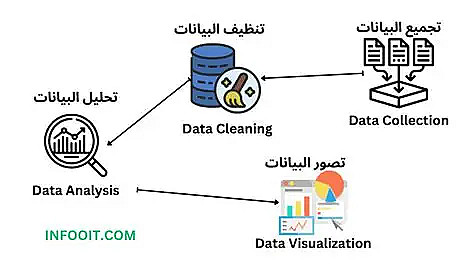

- جمع البيانات (Data Ingestion):

- أدوات مثل Kafka و Flume لجمع البيانات في الوقت الحقيقي.

- تخزين البيانات (Storage):

- قواعد بيانات ضخمة مثل HDFS, AWS S3, Google BigQuery, أو Redshift.

- تنظيف وتحويل البيانات (ETL):

- باستخدام Spark, Airflow, أو AWS Glue.

- يشمل إزالة التكرار، معالجة القيم المفقودة، وتحويل الصيغ.

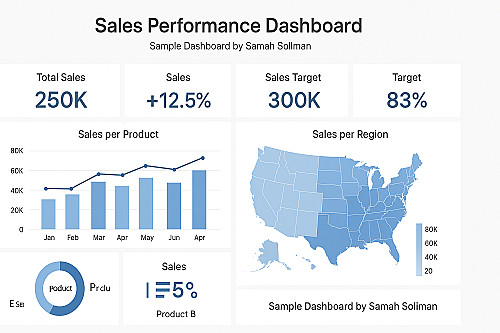

- تحليل البيانات (Analytics):

- التحليل الوصفي (Descriptive) لفهم الماضي.

- التحليل التنبؤي (Predictive) باستخدام Machine Learning.

- التحليل الموجه (Prescriptive) لاتخاذ قرارات مثالية.

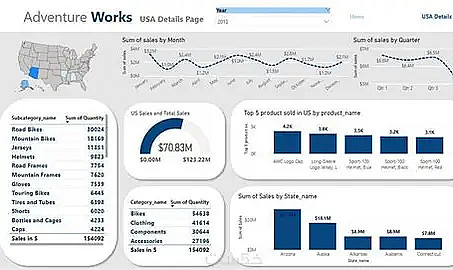

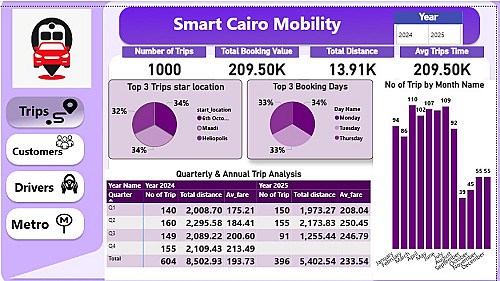

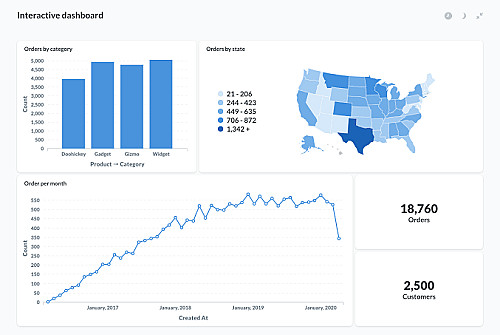

- التصور (Visualization):

- أدوات مثل Tableau, Power BI, أو مكتبات /pandas/numpy/Matplotlib/Seaborn في Python.

البائع

معلومات

العربية

العربية

English

English